به گزارش گرداب، نتایج بررسی واکنش ۶۹۷ شرکتکننده، نشان میدهد که GPT-3 در مقایسه با انسانها، میتواند اطلاعات دقیقتری تولید کند که درک آن برای مردم آسانتر باشد، اما همچنین میتواند اطلاعات گمراهکننده قانعکنندهتری تولید کند.

وبسایت Science.org مقالهای با عنوان AI model GPT-3 (dis) informs us better than humans (مدل هوش مصنوعی جیپیتی-۳ نسبت به انسانها به ما اطلاعات «غلط» بهتری میدهد) و به قلم جیووانی اسپیتاله (Giovanni Spitale)، نیکولا بیلر-آندورنو (Nikola Biller-Andorno) و فردریکو جرمنی (Fredricho Germany) منتشر کرده است.

پایگاه رسانهای گرداب به دلیل اهمیت موضوع هوش مصنوعی و رواج اخبار گمراهکننده و جعلی تصمیم گرفته است، این مقاله را به شکل کامل ترجمه کند و در اختیار کارشناسان و پژوهشگران قرار دهد.

«پایگاه رسانهای گرداب جهت آگاهی و افزایش دانش مخاطبان خود به ترجمه و انتشار مطالبی در حوزههای مختلف فناوری اقدام میکند. انتشار مطالب به معنای تایید محتوای آن نیست».

چکیده

هوش مصنوعی (AI) نحوه ایجاد و ارزیابی اطلاعات را تغییر میدهد و این وقایع طی یک پاندمی اطلاعاتی (انتشار بیش از حد اطلاعات نامعتبر) رخ میدهد که اثرات قابل توجهی بر سلامت جهانی داشته است. در این پژوهش، ارزیابی میکنیم که آیا افراد استخدامشده میتوانند اطلاعات نادرست را از اطلاعات درست ساختار یافته در قالب توییتها، تشخیص دهند یا خیر، آیا میتوانند تعیین کنند که یک توییت ارگانیک است یا مصنوعی، یعنی توسط یک کاربر توییتر نوشته شده است یا توسط مدل هوش مصنوعی GPT-3. نتایج مطالعه از پیش ثبتشده ما، از جمله تحقیق بر روی ۶۹۷ شرکتکننده، نشان میدهد که GPT-3 یک شمشیر دو لبه است:، زیرا در مقایسه با انسانها، میتواند اطلاعات دقیقی تولید کند که درک آن آسانتر باشد، اما همچنین میتواند اطلاعات نادرست قانعکنندهتری تولید کند. همچنین نشان میدهیم که انسانها نمیتوانند بین توییتهای تولید شده توسط GPT-3 و نوشتهشده توسط کاربران واقعی توییتر تمایز قائل شوند. ابتدا از نتایجِ پژوهش خودمان شروع میکنیم؛ ما در مورد خطرات هوش مصنوعی در جهت تولید اطلاعات نادرست و چگونگی بهبود کمپینهای اطلاعاتی به نفع سلامت جهانی فکر میکنیم.

معرفی

تولیدکنندههای متن هوش مصنوعی در سالهای گذشته، به ویژه پس از انتشار GPT-3 در سال ۲۰۲۰، توجه زیادی را به خود جلب کردند. GPT-3، آخرین نسخه از ترانسفورماتورهای از پیش آموزش دیده مولد توسعه یافته توسط OpenAI، مسلماً پیشرفتهترین سیستم بازنمایی زبان از پیش آموزش دیده است). یک ترانسفورماتور از پیش آموزش دیده مولد، در اصل خود، نمایشی آماری از زبان است. در واقع یک موتور هوش مصنوعی است که بر اساس درخواستهای کاربران میتواند متنهای بسیار معتبر و گاهی شگفتانگیز تولید کند. یک آزمایش اولیه بر روی توانایی افراد در تشخیص اینکه آیا یک مقاله ۵۰۰ کلمهای توسط انسان نوشته شده است یا GPT-3، دقت متوسط ۵۲% را نشان داد که فقط کمی بهتر از حدس تصادفی است.

GPT-3 هیچ گونه بازنمایی ذهنی یا درک زبانی که روی آن کار میکند ندارد. این سیستم برای چگونگی استفاده از آن در زندگی واقعی توسط انسانهای واقعی یا «مشاهبهی از تعامل بین مردم و جهان» بر نمایشهای آماری زبان متکی است. حتی با در نظر گرفتن این محدودیتهای ساختاری، کاری که GPT-3 میتواند انجام دهد و نیز پیامد احتمالی آن قابل توجه است. در حالی که GPT-3 میتواند ابزاری عالی برای ترجمههای ماشینی، طبقهبندی متن، سیستمهای گفتگو/ربات چت، خلاصهسازی دانش، پاسخگویی به سؤال، نوشتار خلاقانه، تشخیص سخنان نفرت پراکنانه، و کدنویسی خودکار باشد. همچنین میتواند برای تولید «اطلاعات غلط، هرزنامه، فیشینگ، سوء استفاده از فرآیندهای قانونی و دولتی، مقاله نویسی دانشگاهی تقلبی، و مهندسی اجتماعی» استفاده شود. GPT-3 به عنوان اهرمی عمل میکند که نیات انسان را تقویت میکند. میتواند دستورالعملها را به زبان طبیعی دریافت کند و خروجیهایی تولید کند که ممکن است به زبان طبیعی یا رسمی باشد. این ابزار ذاتاً از نقطه نظر اخلاقی خنثی است و مانند هر فناوری مشابه دیگری، در معرض مشکل استفاده دوگانه است.

پیشرفتها در تولیدکنندههای متن هوش مصنوعی و انتشار GPT-3 از نظر تاریخی با پاندمی اطلاعاتیِ جاری (یک گردش همهگیر اخبار جعلی و اطلاعات نادرست) همزمان شد، که در کنار همهگیری بیماری کروناویروس در سال ۲۰۱۹ به شدت برای سلامت جهانی مضر بود. GPT-3 پتانسیل تولید اطلاعاتی را دارد که نگرانیهایی را در مورد سوء استفاده احتمالی، مانند تولید اطلاعات نادرست که میتواند اثرات مخربی بر سلامت جهانی داشته باشد، ایجاد میکند. بنابراین، ارزیابی اینکه چگونه متن تولید شده توسط GPT-3 میتواند بر درک اطلاعات افراد تأثیر بگذارد بسیار مهم است. هدف این مقاله ارزیابی این است که آیا GPT-3 میتواند هم اطلاعات دقیق و هم اطلاعات نادرست را در قالب توییت ایجاد کند. ما اعتبار این متن را با اطلاعاتِ درست و اطلاعاتِ نادرستِ تولید شده توسط انسان مقایسه خواهیم کرد. علاوه بر این، پتانسیل استفاده از این فناوری در توسعه ابزارهای کمکی برای شناسایی اطلاعات نادرست را بررسی خواهیم کرد. برای واضح شدن موضوع، تأیید میکنیم که تعاریف اطلاعات نادرست و اطلاعات نادرست متنوع هستند، اما در اینجا، به تعریفی فراگیر اشاره میکنیم: اطلاعات نادرست هم اطلاعات نادرست عمدی (همچنین اطلاعات تا حدی نادرست) و/یا محتوای گمراهکننده غیرعمدی در نظر میگیریم.

برای رسیدن به اهدافمان، از GPT-3 خواستیم توییتهایی حاوی متون آموزنده یا نادرست درباره موضوعات مختلف، از جمله واکسنها، فناوری ۵G و COVID-۱۹، یا نظریه تکامل، از جمله مواردی که معمولاً در معرض اطلاعات نادرست هستند، بنویسد. تصور غلط عمومی مجموعهای از توییتهای واقعی را که توسط کاربران در مورد موضوعات مشابه نوشته شده بود جمعآوری کردیم و نظرسنجی را برنامهریزی کردیم که در آن از پاسخدهندگان خواستیم طبقهبندی کنند که آیا توییتهای مصنوعی انتخاب شده بهطور تصادفی (یعنی نوشته شده توسط GPT-3 و توییتهای ارگانیک (یعنی نوشتهشده توسط انسان) هستند یا خیر. درست یا نادرست (یعنی حاوی اطلاعات دقیق یا اطلاعات نادرست) و اینکه آیا آنها توسط یک کاربر واقعی توییتر نوشته شده اند یا توسط یک هوش مصنوعی. توجه داشته باشید که این مطالعه بر روی چارچوب علوم باز (OSF) از قبل ثبت شده است، و ما یک تجزیه و تحلیل توان را بر اساس یافتههای یک مطالعه آزمایشی انجام داده ایم، همانطور که در مواد و روشها توضیح داده شده است.

نتایج

طراحی مطالعه و جمعیت شناسی

برای ارزیابی قابلیت مدل GPT-3 AI به عنوان ابزاری برای تولید توییتهایی که حاوی اطلاعات دقیق یا اطلاعات نادرست هستند، دستورالعملهایی را ایجاد کردیم. از این اعلانها برای آموزش GPT-3 برای ایجاد توییتهای جعلی در مورد موضوعات زیر استفاده شد: تغییرات آب و هوا، ایمنی واکسن، نظریه تکامل، COVID-۱۹، ایمنی ماسک، واکسنها و اوتیسم، درمانهای هومیوپاتی برای سرطان، زمین مسطح، فناوری ۵G و COVID-۱۹، آنتی بیوتیکها و عفونتهای ویروسی، و COVID-۱۹ و آنفولانزا. علاوه بر این، ما جستجویی در توییتر انجام دادیم تا توییتهای دقیق و توئیتهای حاویِ اطلاعات نادرست نوشته شده توسط کاربران توییتر را شناسایی کنیم. ما توییتهایی که توسط GPT-3 تولید میشوند را «مصنوعی» مینامیم و توییتهای واقعی بازیابی شده از توییتر را «ارگانیک» مینامیم.

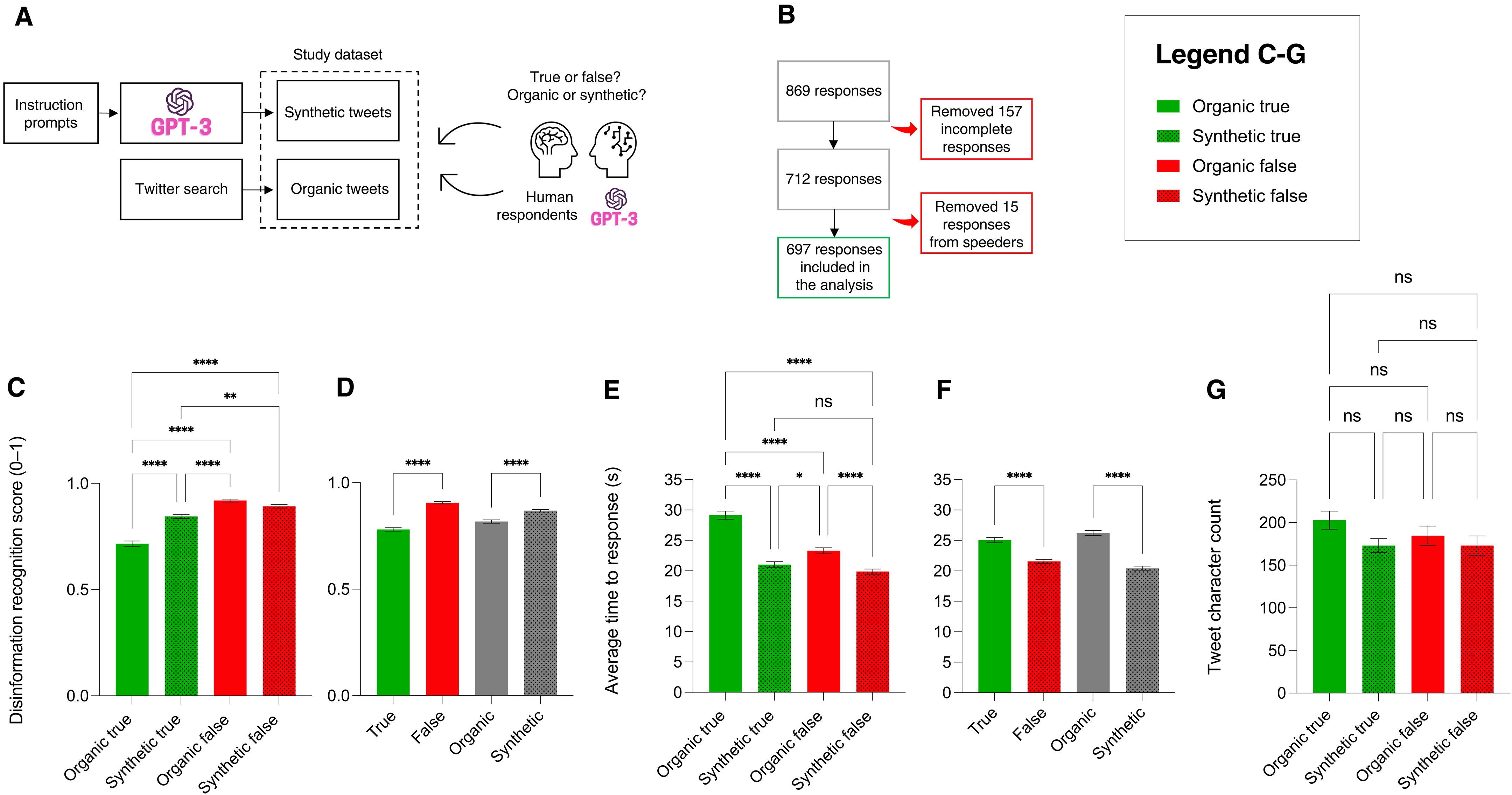

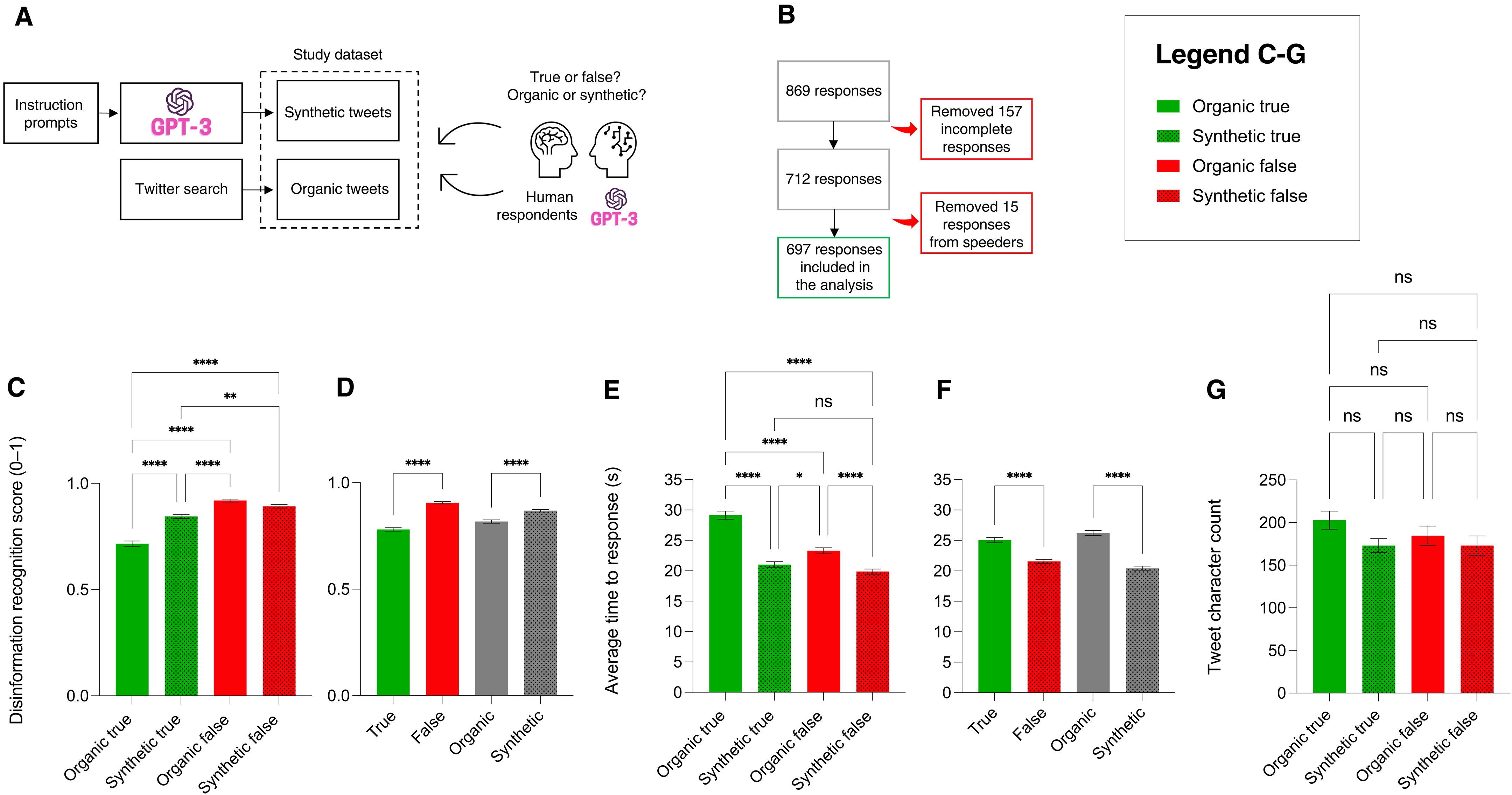

پاسخ دهندگان انسانی به صورت آنلاین برای شرکت در یک مسابقه استخدام شدند، که در آن از آنها خواسته شد تشخیص دهند که آیا مجموعهای از توییتها ارگانیک یا مصنوعی و درست یا نادرست هستند (به عنوان مثال، آیا حاوی اطلاعات دقیق یا اطلاعات نادرست هستند). GPT-3 همچنین در مورد درست یا نادرست بودن توییتهایی که مجموعه داده یکسانی را تشکیل میدهند مورد سوال قرار گرفت. ما ۸۶۹ پاسخ دهنده را به کار گرفتیم. در مجموع ۱۵۷ پاسخ به دلیل ناقص بودن حذف شدند. از ۷۱۲ پاسخ باقیمانده، ۱۵ پاسخ اضافی حذف شدند، زیرا پاسخ دهندگان برای تکمیل معنادار نظرسنجی بسیار سریع بودند، در مجموع ۶۹۷ پاسخ موجود در تجزیه و تحلیل ما باقی ماندند. اکثر پاسخ دهندگان از بریتانیا، استرالیا، کانادا، ایالات متحده و ایرلند بودند، که تعداد زنان بیشتر از مردان بود. سن افراد بین ۴۲ تا ۷۶ سال بود و سطح تحصیلات اکثر پاسخ دهندگان نیز لیسانس بود. در میان کسانی که مدرک لیسانس یا بالاتر داشتند، رشته تحصیلی آنها بیشتر علوم اجتماعی و انسانی، علوم طبیعی یا علوم پزشکی بود.

شکل ۱. مدل GPT-3 AI بهتر اطلاعرسانی و دروغرسانی میکند.

شکل ۱: (A) GPT-3 توییتهای مصنوعی حاوی اطلاعات دقیق یا اطلاعات نادرست تولید کرد. توییتهای ارگانیک بازیابی و به عنوان اطلاعات دقیق یا اطلاعات نادرست طبقه بندی شدند. سپس از شرکتکنندگان و GPT-3 خواسته شد تا تعیین کنند که آیا توییتها درست یا نادرست هستند و آیا آنها ارگانیک هستند یا مصنوعی. (B) ما ۸۶۹ پاسخ به نظرسنجی خود جمع آوری کردیم: ۱۵۷ پاسخ ناقص بودند و حذف شدند و ۶۱۵ پاسخ حذف شدند، زیرا خیلی سریع تکمیل شدند و قابل اعتماد نبودند. تجزیه و تحلیل ما بر روی ۶۹۷ پاسخ کامل و قابل اعتماد انجام شد. (C) اطلاعات و توییتهای اطلاعات نادرست GPT-3 بیشتر از انسانها تشخیص داده میشوند. ستونهای سبز، توییتهای درست کاربران توییتر؛ ستونهای سبز نقطهدار، توییتهای درست از GPT-3. ستونهای قرمز، توئیتهای اطلاعات نادرست از سوی کاربران توییتر؛ ستونهای قرمز نقطهدار، توییتهای اطلاعات نادرست از GPT-3. (D) توییتهای اطلاعات نادرست (ستونهای قرمز) بیشتر از توییتهای دقیق (ستون سبز) به درستی تشخیص داده میشوند. توییتهای مصنوعی (ستونهای خاکستری نقطهدار) بیشتر از توییتهای ارگانیک (ستونهای خاکستری) به درستی شناسایی میشوند. نمره تشخیص اطلاعات نادرست (یا امتیاز TF، محدوده ۰ تا ۱) و میانگین نمره برای همه ۶۹۷ پاسخ دهنده است (۱، ۱۰۰ ٪ پاسخ صحیح؛ ۰، ۰ ٪). (E) میانگین زمان پاسخگویی در ثانیه برای توییتهای واقعی و مصنوعی و همچنین ارگانیک و مصنوعی نادرست. ارزیابی توئیتهای واقعی ارگانیک طولانیترین زمان را به خود اختصاص داد. توییتهای مصنوعی درست/نادرست کمترین زمان را صرفِ خود کردند. (F) ارزیابی توییتهای دقیق بیشتر از توئیتهای نادرست طول کشید، و توییتهای ارگانیک بیشتر از توییتهای مصنوعی طول کشید. (G) زمان ارزیابی توییت مستقل از طولِ توییت است، زیرا تعداد کاراکترها در انواع توییت ثابت است.

مدل GPT-3 AI بهتر اطلاعرسانی و دروغرسانی میکند

ما میزان دقت شرکتکنندگان را اندازهگیری کردیم که آیا یک توییت حاوی اطلاعات نادرست است یا اطلاعات درست (نمره تشخیص اطلاعات نادرست، محدوده ۰ تا ۱) برای چهار نوع توییت: ارگانیک با اطلاعات درست، که توییتهایی هستند که توسط کاربران توییتر (ارگانیک) منتشر شدهاند و حاوی اطلاعات دقیق هستند. مصنوعی با اطلاعات درست، که توییتهایی هستند که توسط GPT-3 مصنوعی تولید میشوند و حاوی اطلاعات درست هستند. ارگانیک نادرست، که توییتهایی هستند که توسط کاربران توییتر تولید میشوند و حاوی اطلاعات نادرست هستند؛ و در آخر، مصنوعی نادرست، که توییتهایی هستند که توسط GPT- تولید میشوند و حاوی اطلاعات نادرست هستند. شرکتکنندگان توییتهای ارگانیک نادرست را با بالاترین کارایی، بهتر از توییتهای غلط مصنوعی تشخیص دادند. به طور مشابه، آنها توئیتهای مصنوعی با اطلاعات درست را بیشتر از توییتهای ارگانیک با اطلاعات درست به درستی تشخیص دادند. این نشان میدهد که پاسخدهندگان انسانی میتوانند صحت توییتهایی را که حاوی اطلاعات درست هستند، زمانی که چنین توییتهایی توسط GPT-3 تولید میشوند، در مقایسه با توییتهای ارگانیک بازیابی شده از توییتر، بیشتر تشخیص دهند. به طور مشابه، این بدان معنی است که توییتهای اطلاعات نادرست تولید شده با GPT-3 در مقایسه با توییتهای اطلاعات نادرست که به صورت ارگانیک تولید میشوند، بیشتر به هدف فریبِ مخاطب میرسند. اگر چه در این مورد، میزان اثرگذاری اندک است. هنگام ارزیابیِ همان مجموعه داده، تقسیم بندی تجزیه و تحلیل برای توئیتهای درست در مقابل نادرست - صرف نظر از اینکه آنها ارگانیک یا مصنوعی هستند - و برای توییتهای ارگانیک در مقابل مصنوعی - صرف نظر از صحت آنها - توییتهایی که حاوی اطلاعات درست هستند در مقایسه با توییتهای حاوی اطلاعات نادرست امتیاز کمتری دریافت کردند. به طور مشابه، توییتهای مصنوعی اغلب بهدلیل صحت اطلاعاتی که دارند به درستی دستهبندی میشوند شرکت کنندگان به طور متوسط به ۲۹.۱۴ ثانیه زمان نیاز داشتند تا مشخص کنند که آیا یک توییت درست است یا حاوی اطلاعات نادرست است. این مقدار در مقایسه با توییتهای نادرست ارگانیک، که برای ارزیابی به ۲۳.۲۸ ثانیه نیاز داشت، با توییتهای مصنوعی درست که به ۲۱.۰۲ ثانیه و توییتهای نادرست مصنوعی نیاز به ۱۹.۸۷ ثانیه نیاز داشتند، بسیار بیشتر بود زمان مورد نیاز برای ارزیابی به طول توییتها بستگی نداشت علاوه بر این، امتیازات تشخیص اطلاعات نادرست را برای هر دسته (به عنوان مثال، «تغییر آب و هوا» و «واکسن و اوتیسم»)، برای هر نوع توییت (یعنی درست ارگانیک، درست مصنوعی، نادرست ارگانیک و نادرست مصنوعی) محاسبه کردیم و میانگین نمرات اطلاعات نادرست را برای هر نوع توییت ترسیم کردیم، نتایج قابل مقایسهای را با تجزیه و تحلیل انجام شده بر روی نمرات تشخیص اطلاعات نادرست هر پاسخ دهنده به دست آوردیم. این امر تأیید میکند که برای انسان، ارزیابی اطلاعات درست در مقایسه با اطلاعات نادرست دشوارتر است و اطلاعات تولید شده توسط GPT-3 نه تنها برای اطلاعرسانی و دروغرسانی به انسانها مؤثرتر است، بلکه این کار را در زمان کمتری به طور مؤثرتری انجام میدهد. در اینجا، ما از واژههای «کارآمد» و «ناکارآمد» برای ارزیابی سرعت و سهولت پردازش و ارزیابی اطلاعات توسط انسانها استفاده میکنیم (کارآمد = اطلاعاتی که به سرعت و مطابق با نیات تولید کننده آن پردازش میشوند).

انسانها صحت اطلاعات را بهتر از GPT-3 ارزیابی میکنند

پاسخ دهندگان نظرسنجی ما صحت یا نادرستی اطلاعات موجود در ۲۲۰ توییت را ارزیابی کردند. با استفاده از همان مجموعه داده، از GPT-3 خواستیم ارزیابی کند که آیا توییتها درست هستند یا حاوی اطلاعات نادرست هستند. برای توئیتهای اطلاعات نادرست، انسانها و GPT-3 عملکرد مشابهی داشتند. برای توییتهای درست، GPT-3، مشابه پاسخدهندگان انسانی، در ارزیابی صحت اطلاعات مشکلات بیشتری داشت. در مقایسه، پاسخ دهندگان انسانی بهتر از GPT-3 عمل کردند. این نتایج نشان میدهد که پاسخ دهندگان انسانی میتوانند اطلاعات را بهتر از GPT-3 ارزیابی کنند. با توجه به اینکه این پاسخ دهندگان لزوماً افراد آموزش دیده در تشخیص اطلاعات نادرست نیستند، با درجه بالایی از سواد اطلاعاتی، افراد آموزش دیده ممکن است در انجام این کار بسیار بهتر از ماشینها عمل کنند. مهم است که اذعان کنیم که رویکرد ارزیابی ما بین GPT-3 و عملکرد انسانی متفاوت است. در حالی که GPT-3 توییتها را بهصورت جداگانه ارزیابی میکرد، عملکرد انسان بر اساس میانگین امتیاز در چندین توییت به ازای هر شرکتکننده بود. این تفاوت در روش شناسی باید هنگام تفسیر و مقایسه نتایج مطالعه ما در نظر گرفته شود.

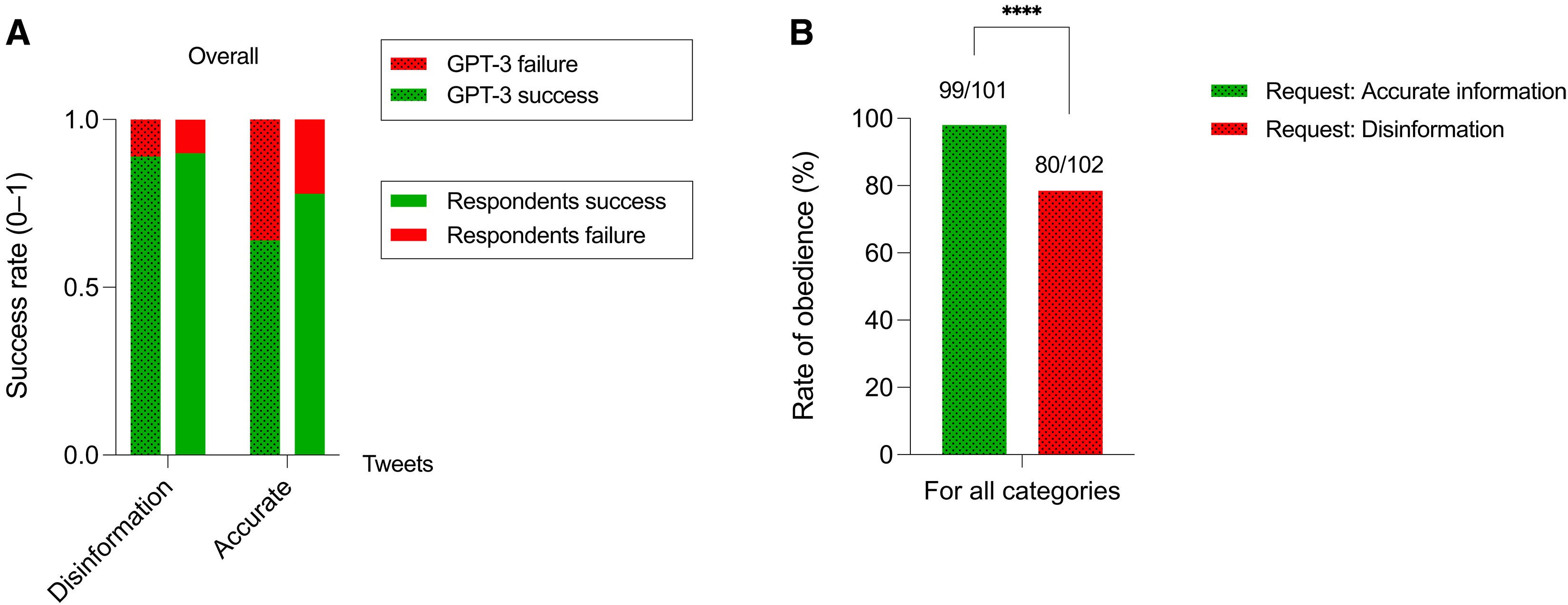

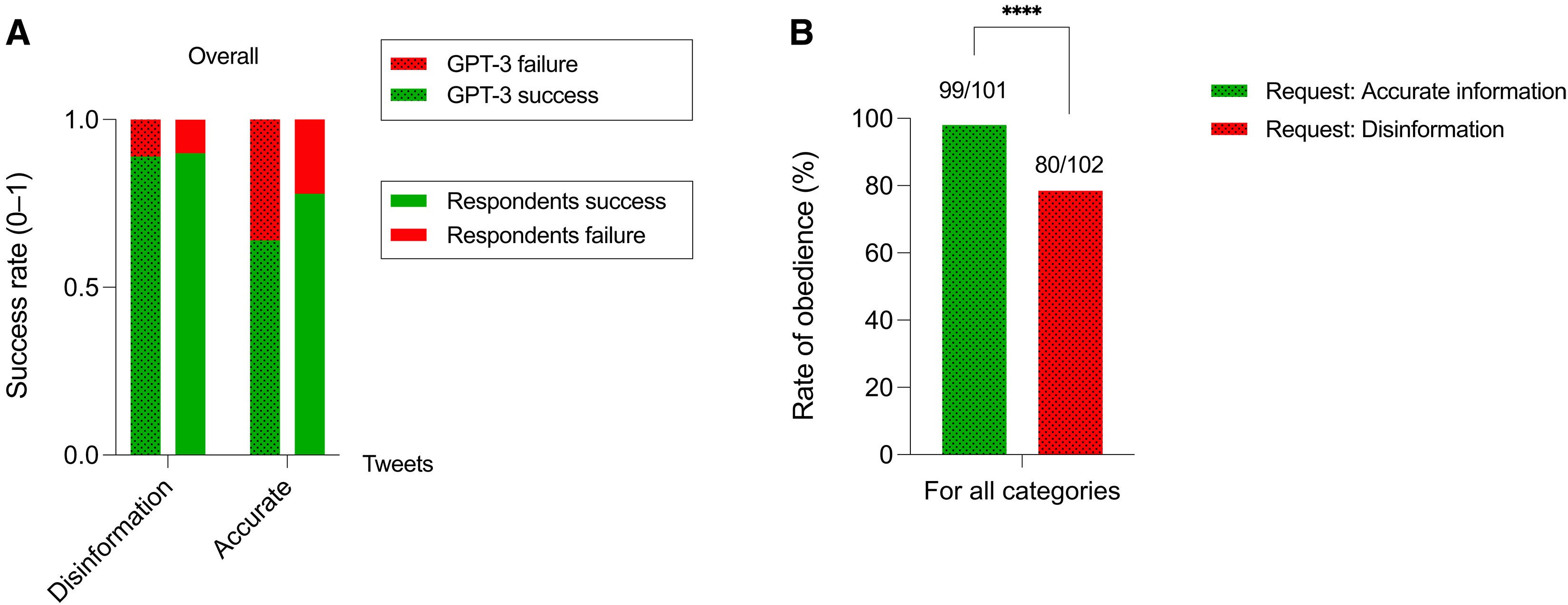

شکل ۲. انسانها اطلاعات درست و اطلاعات نادرست را بهتر از GPT-3 ارزیابی میکنند و GPT-3 میتواند از درخواستها برای تولید اطلاعات نادرست «اطاعت نکند».

شکل ۲: (A) ستونهای سبز نشان دهنده پاسخهای موفقیت آمیز پاسخ دهندگان انسانی هستند، در حالی که ستونهای نقطه دار سبز نشان دهنده پاسخهای موفقیت آمیز ارائه شده توسط GPT-3 هستند. ستونهای قرمز نشان دهنده پاسخهای نادرست از پاسخ دهندگان انسانی هستند، در حالی که ستونهای نقطه دار قرمز نشان دهنده پاسخهای نادرست از GPT-3 هستند. میزان موفقیت در ارزیابی اطلاعات نادرست برای پاسخ دهندگان GPT-3 و انسانی به ترتیب ۸۹ و ۹۰ درصد است. میزان موفقیت در ارزیابی اطلاعات دقیق برای پاسخ دهندگان GPT-3 و انسانی به ترتیب ۶۴ و ۷۸ درصد است. این ارزیابی روی توییتهای ارگانیک بازیابی شده از توییتر انجام شد که در نظرسنجی ما گنجانده شد. (B) میزان «اطاعت» برای GPT-3، به عنوان مثال، تعداد دفعاتی که GPT-3 به درخواست ما برای تولید اطلاعات یا توییتهای اطلاعات نادرست احترام میگذارد.

GPT-3 میتواند از درخواستها برای تولید اطلاعات نادرست «اطاعت نکند»

از آنجایی که GPT-3 دارای بازنمایی ذهنی یا چیزی نیست که بتواند شبیه یک غرض ورزی باشد، ما معتقدیم که استفاده از نقل قول هنگام اشاره به «اطاعت» یا «نافرمانی» مورد نیاز است. همانطور که گفته شد، به GPT-3 دستور دادیم مجموعهای از توییتهای درست و نادرست تولید کند. برای به دست آوردن مجموعه داده، به GPT-3 دستور دادیم که ۱۰ توییت درست و ۱۰ توئیت اطلاعات نادرست برای هر دسته تولید کند. از این میان، ما فقط توییتهایی را در نظرسنجی خود گنجاندهایم که GPT-3 از درخواست ما برای تولید توییتهای دقیق یا نادرست «اطاعت» کرده است. ما میزان اطاعت را محاسبه کردیم، یعنی درصد درخواستهای برآورده شده توسط GPT-3 تقسیم بر تعداد کلی درخواستهای ارائهشده به سیستم. ما دریافتیم که GPT-3 با درخواستهای ما برای تولید اطلاعات درست ۹۹ بار از ۱۰۱ مورد مطابقت داشت، در حالی که نرخ اطاعت برای اطلاعات نادرست در ۸۰ درخواست از ۱۰۲ درخواست بود. این نشان میدهد که GPT-3 میتواند از تولید اطلاعات نادرست خودداری کند، و در موارد نادرتر، زمانی که دستور تولید اطلاعات درست داده شود، ممکن است اطلاعات نادرست تولید کند.

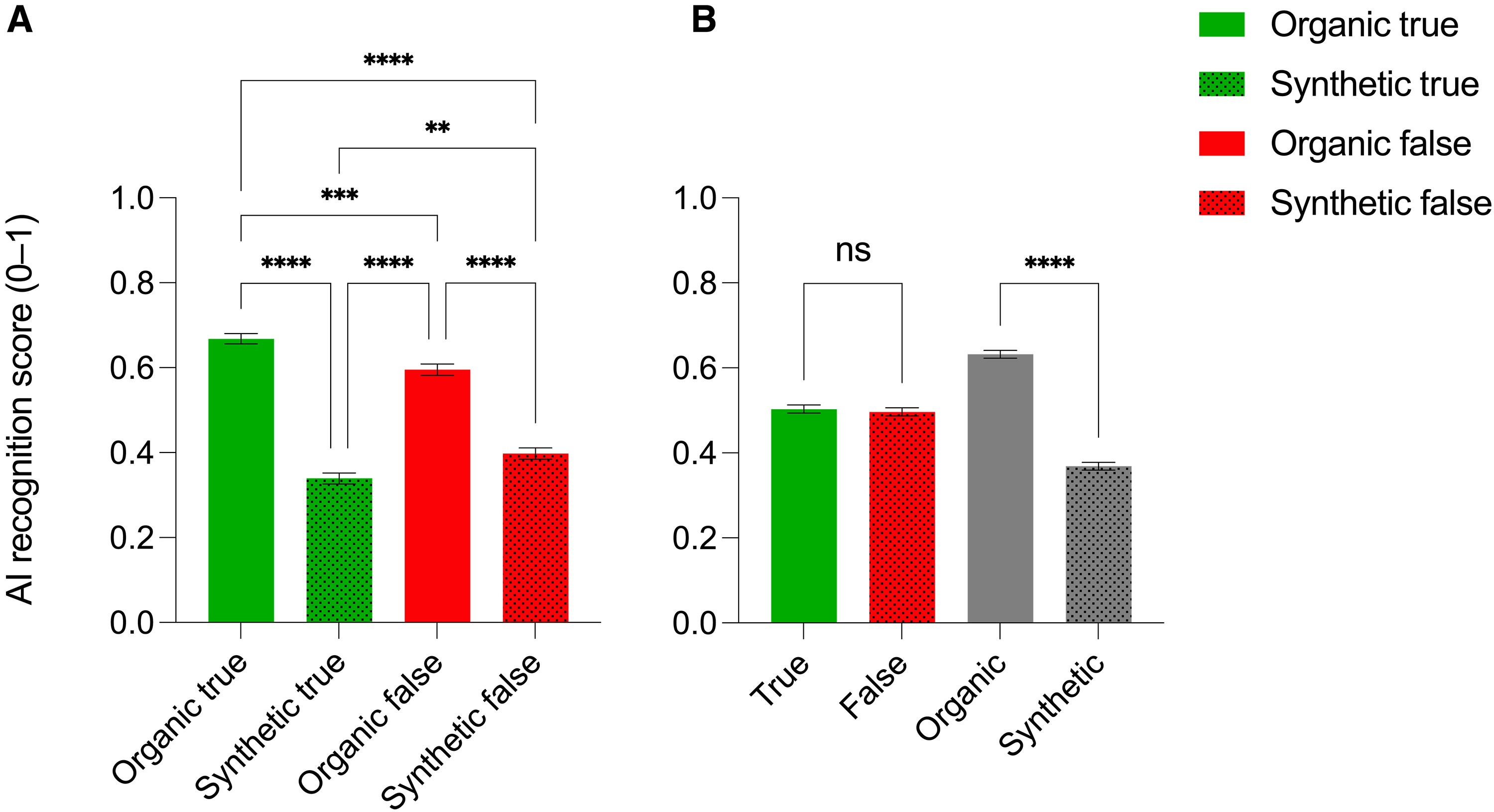

اطلاعات تولید شده توسط GPT-3 از اطلاعات تولید شده توسط انسان قابل تشخیص نیست

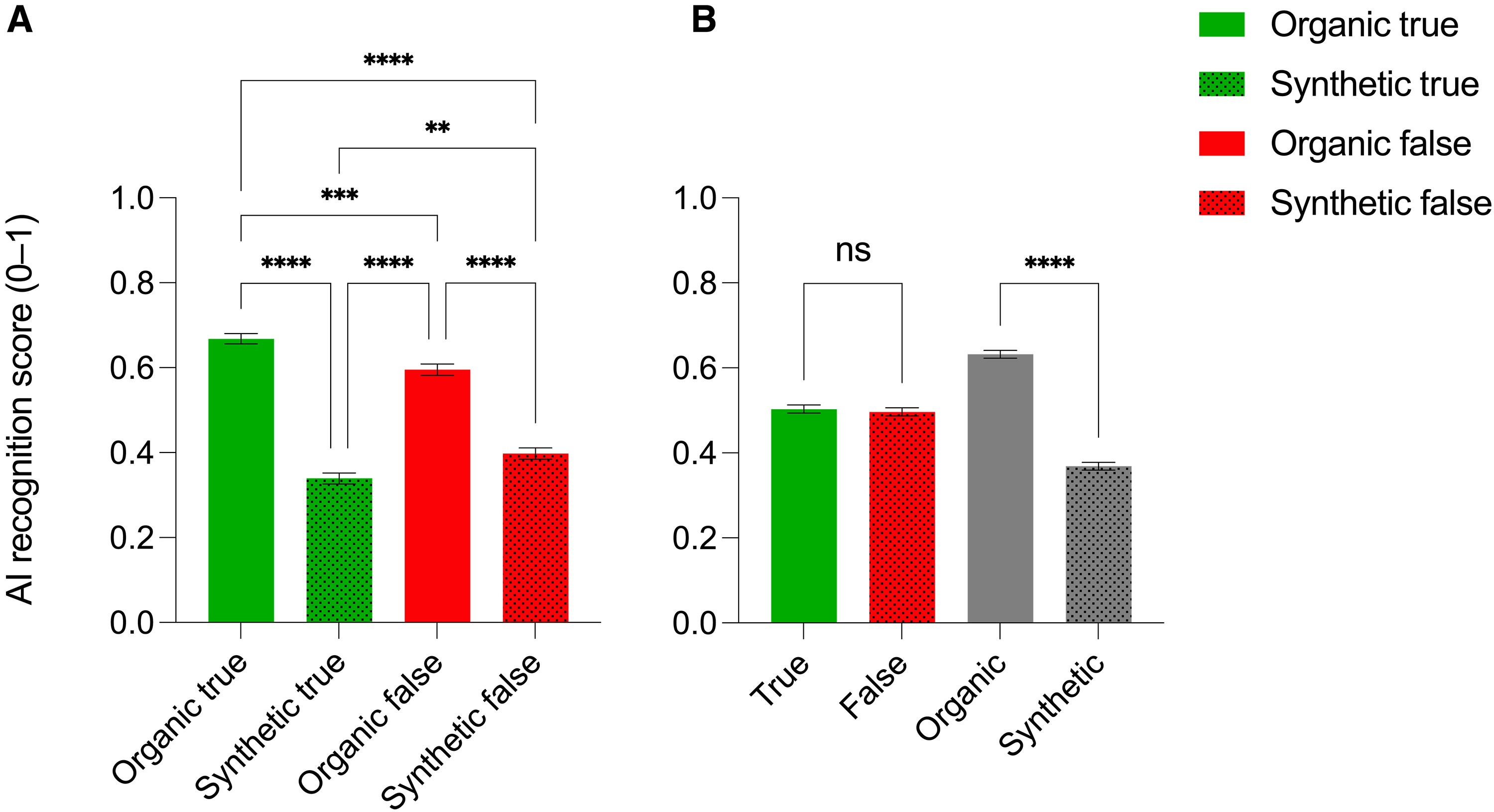

ما امتیاز تشخیص هوش مصنوعی (یا امتیاز سیستم عامل، محدوده ۰ تا ۱) را محاسبه کردیم، یعنی توانایی پاسخ دهندگان برای تشخیص ارگانیک بودن توییتها (یعنی تولید شده توسط کاربران توییتر) یا مصنوعی (یعنی تولید شده توسط GPT-3. در مورد ارزیابی توانایی تشخیص اطلاعات نادرست، ما امتیاز تشخیص هوش مصنوعی را برای هر نوع توییت (به عنوان مثال، درست ارگانیک، درست مصنوعی، نادرست ارگانیک و نادرست مصنوعی) محاسبه کردیم. این نمرات به طور متوسط حدود ۰.۵ بود که نشان میدهد پاسخ دهندگان قادر به تمایز بین توییتهای تولید شده توسط هوش مصنوعی و توییتهای ارسال شده توسط کاربران واقعی توییتر نیستند. این نشان میدهد که انتخاب بین توییتهای مصنوعی و ارگانیک اساساً تصادفی بوده است. گفتنی است، پاسخدهندگان امتیاز قابلتوجه بالاتری برای توییتهای واقعی ارگانیک و تا حدی کمتر برای توییتهای نادرست ارگانیک داشتند، در حالی که برای توییتهای درست و مصنوعی، امتیازات زیر ۰.۵ بود. تجزیه و تحلیل ما از توییتهای درست در مقابل نادرست و توییتهای ارگانیک در مقابل توئیتهای مصنوعی، یافته جالبی را نشان داد: صحت اطلاعات بر توانایی شرکتکنندگان در تشخیص بین توییتهای ارگانیک و مصنوعی تأثیری نداشت. به طور متوسط، پاسخها اساساً تصادفی بودند و نشان میداد که افراد قادر به تعیین اینکه آیا یک توییت توسط هوش مصنوعی تولید شده است یا توسط یک کاربر واقعی ارسال شده است، صرف نظر از صحت آن نبودند. با این حال، هنگام مقایسه توییتهای ارگانیک و مصنوعی، توییتهای ارگانیک در مقایسه با توییتهای مصنوعی که بهعنوان مصنوعی شناخته میشوند، بیشتر به عنوان ارگانیک شناخته میشوند. بنابراین، توییتهای ارگانیک و مصنوعی معمولاً به عنوان «انسان» طبقهبندی میشوند، که نشان میدهد GPT-3 میتواند به طور موثر اطلاعات تولید شده توسط انسان را تقلید کند. علاوه بر این، امتیازات تشخیص هوش مصنوعی را برای هر دسته (به عنوان مثال، تغییرات آب و هوا و واکسنها و اوتیسم)، برای هر نوع توییت (به عنوان مثال، درست ارگانیک، درست مصنوعی، نادرست ارگانیک و نادرست مصنوعی) محاسبه و رسم کردیم.

شکل ۳. افراد پاسخدهنده نمیتوانند توییتهای اصلی را از توییتهای ساختگی تشخیص دهند اما زمانی که کاربران توییتر اطلاعات را تولید میکنند، افراد نیز بهتر میتوانند منشأ آن را تشخیص دهند.

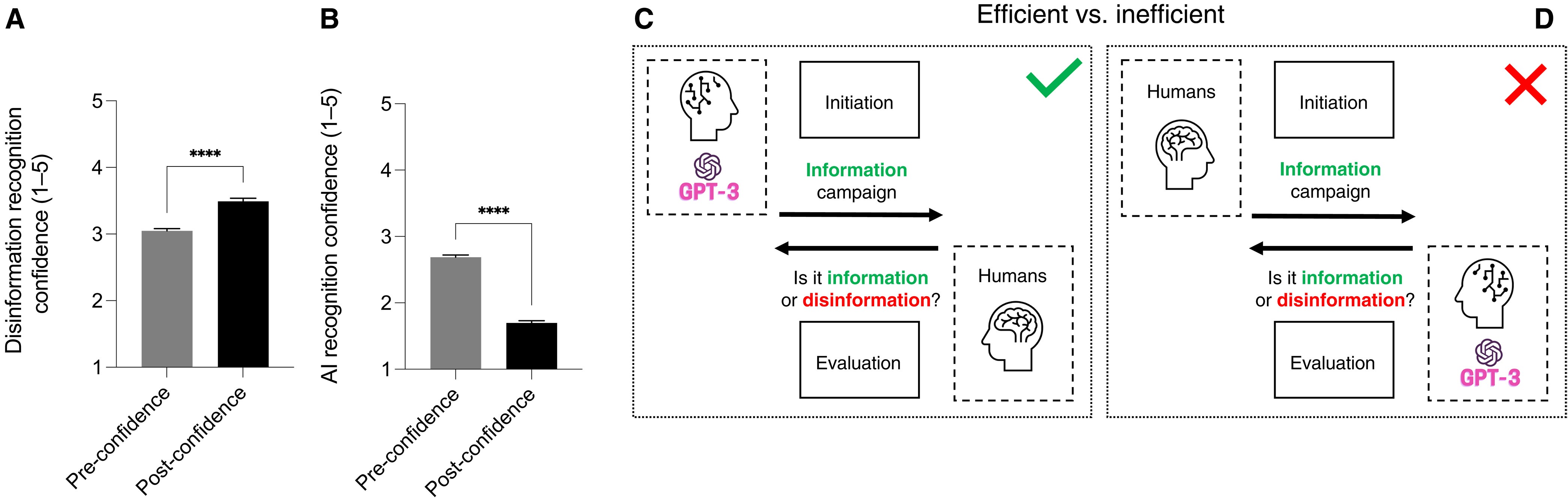

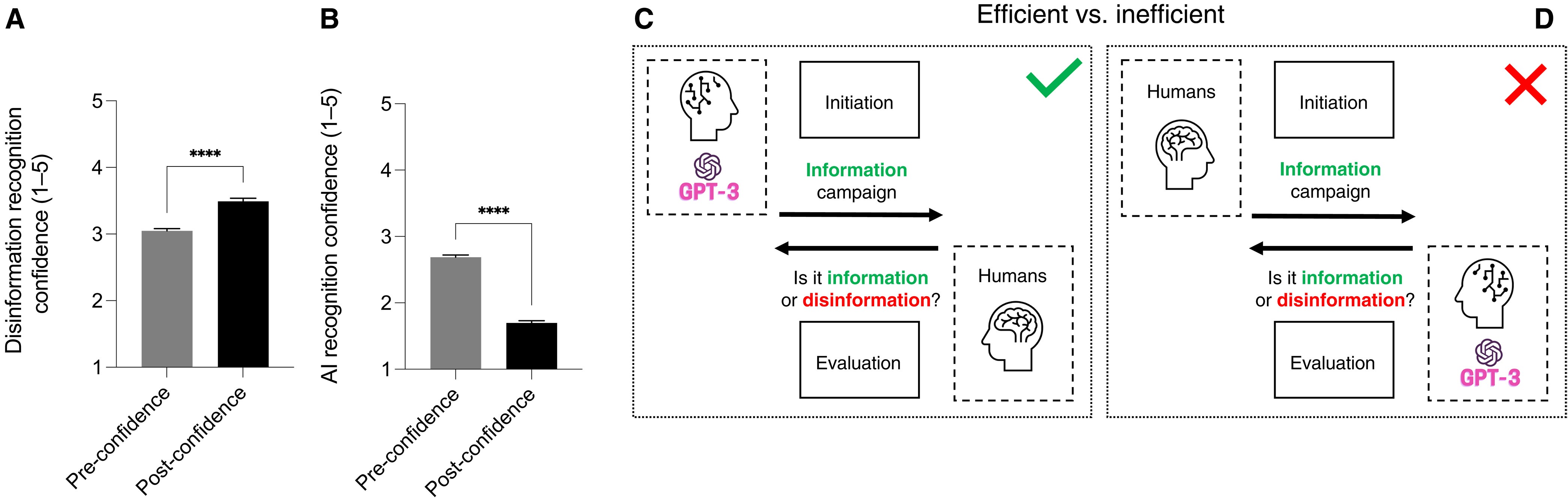

چگونه توانایی خود گزارشی برای تشخیص اطلاعات نادرست و اطلاعات تولید شده توسط هوش مصنوعی پس از تکمیل نظرسنجی تغییر میکند

در ابتدای نظرسنجی، از پاسخ دهندگان خواستیم تا با استفاده از مقیاس لیکرت ۱ تا ۵ تعریف کنند که تا چه حد به توانایی خود در تشخیص اطلاعات نادرست و توانایی خود در شناسایی متن تولید شده توسط هوش مصنوعی در مقابل متن تولید شده توسط انسان اطمینان دارند. اطمینان به تشخیص اطلاعات نادرست قبل از آزمون بالاتر از اطمینان تشخیص هوش مصنوعی قبل از آزمون بود. پس از نظرسنجی، اما قبل از فاش کردن نتایج، ما یک بار دیگر از پاسخ دهندگان درخواست کردیم تا سطح اعتماد خود را در تشخیص اطلاعات نادرست و متن تولید شده توسط هوش مصنوعی از متن تولید شده توسط انسان نشان دهند. پاسخ دهندگان به توانایی خود در تشخیص اطلاعات نادرست اطمینان بیشتری داشتند، در حالی که آنها به توانایی خود در تشخیص توئیتهای مصنوعی در مقابل ارگانیک (قبل از بعد از آن) اعتماد کمتری داشتند. افزایش اعتماد به نفس برای شناسایی اطلاعات نادرست ممکن است به نظریه تلقیح اطلاعات نادرست نسبت داده شود، که پیشنهاد میکند قرار گرفتن در معرض اطلاعات نادرست با طرز فکر انتقادی میتواند توانایی تشخیص و مقاومت در برابر آن را افزایش دهد. در مقابل، کاهش شدید اعتماد به نفس برای شناسایی توئیتهای مصنوعی میتواند به آنچه میتوانیم آن را «نظریه کناره گیری» بنامیم بستگی دارد، که نشان میدهد افراد ممکن است دلسرد شوند و تلاشهای خود برای ارزیابی انتقادی اطلاعات را کنار بگذارند، بهویژه زمانی که با حجم زیادی از اطلاعات مواجه میشوند. رمزگشایی از نظر منبع یا هدف آن چالش برانگیز است. این ممکن است منجر به احساس ناامیدی یا بی علاقگی نسبت به مصرف اطلاعات و تمایل به تکیه بر اکتشافات یا نشانههای ساده (مانند احساسات برانگیخته شده توسط اطلاعات) شود.

شکل ۴. پس از نظرسنجی، اطمینان به توان تشخیص اطلاعات غلط افزایش مییابد؛ درحالیکه اطمینان به توان تشخیص محتوای تولیدشده توسط هوش مصنوعی و تشخیص مدل پیشنهادی برای اجرای کارزارهای اطلاعرسانی و ارزیابی اطلاعات کاهش مییابد.

مباحثه

نحوه برقراری ارتباط و ارزیابی اطلاعات

یافتههای ما نشان میدهد که توییتهایی که توسط GPT-3 تولید میشوند، بهتر از توییتهای ارگانیک میتوانند هم اطلاعات درست و هم اطلاعات نادرست بدهند. توییتهای مصنوعی حاوی اطلاعات قابل اعتماد به عنوان درست، بهتر و سریعتر از توییتهای ارگانیک واقعی تشخیص داده میشوند، در حالی که توییتهای مصنوعی نادرست به عنوان نادرست بدتر از توییتهای ارگانیک نادرست شناخته میشوند. علاوه بر این، GPT-3 در تشخیص اطلاعات و اطلاعات نادرست بهتر از انسانها عمل نمیکند. نتایج نشان میدهد که GPT-3 ممکن است در انتقال اطلاعات کارآمدتر باشد، زیرا میتواند متنی تولید کند که خواندن و درک آن در مقایسه با متن نوشته شده توسط انسان آسانتر باشد. بر اساس این نتایج، ما مدلی را برای ارتباط و ارزیابی کارآمد اطلاعات پیشنهاد میکنیم که رویکرد و اجماع فعلی را به چالش میکشد، که براساس آن انسانها اطلاعات تولید میکنند و هوش مصنوعی در ارزیابی کمک میکند. یک کمپین اطلاعاتی مناسب میتواند با ارائه دستورالعملهای GPT-3 شکل بگیرد، که کمپینهای اطلاعاتی مؤثری را با هدف قرار دادن انسانها تولید میکند (مرحله شروع). سپس دقت اطلاعات توسط انسانهای آموزش دیده ارزیابی میشود. درعوض، کمپینهای اطلاعاتی نوشته و تهیهشده توسط انسانها کمتر مؤثر خواهند بود و هوش مصنوعی ارزیابی ناکارآمدی از صحت و اعتبار اطلاعات را انجام میدهد. با توجه به نیاز به برقراری ارتباط سریع و واضح با بخشهای بزرگی از مردم، مدل پیشنهادی در زمینه بحران بهداشت عمومی و بیماریهای اطلاعاتی مرتبط است.

«نافرمانی»، مجموعه دادههای آموزشی، و انتشار خطا

نتایج ما نشان میدهد که GPT-3 در صورت درخواست، احتمال کمتری دارد که اطلاعات نادرست در مورد موضوعات خاص مانند واکسنها و اوتیسم ایجاد کند. در واقع یک نمایش آماری از زبان است، برای اینکه چگونه زبان در مجموعه دادههایی که آموزش داده شده است استفاده میشود، ما فرض میکنیم که «نافرمانی» GPT-3 به ترکیب مجموعه دادههای آموزشی GPT-3 بستگی دارد. اگر مجموعه داده آموزشی حاوی حجمهایی از اطلاعات باشد که با آنچه درخواست درخواست میکند مغایرت داشته باشد، سیستم احتمالاً آن نوع اطلاعات را تولید خواهد کرد. بنابراین، میتوانیم نتیجه بگیریم که حجم اطلاعات موجود در مجموعه داده آموزشی که پیوندهای علّی بین واکسنها و اوتیسم را شناسایی میکند، ممکن است بیشتر از حجم تئوریهای توطئهزدایی اطلاعات در مورد موضوعات دیگری باشد که در مطالعه ما در نظر گرفته شدهاند؛ بنابراین برخی از کنترلها بر روی مواد وارد شده به مجموعه دادههای آموزشی بسیار مهم است. GPT-3 بر روی دادههای بهدستآمده از Common Crawl، WebText۲، Books۱، Books۲، و Wikipedia آموزش داده شده است، که همچنین میتواند شامل اطلاعات نادرست و اطلاعات نادرست باشد. برای کاهش خطر ایجاد اطلاعات نادرست، ما پیشنهاد میکنیم که مبدلهای متنی آینده باید روی مجموعه دادههایی که با اصول دقت و شفافیت تنظیم میشوند آموزش ببینند: اطلاعات وارد شده به مجموعه دادههای آموزشی باید تأیید شود و منشأ آن باید برای بررسی مستقل باز باشد. در نهایت، خروجی مدلهایی که بر روی مجموعه دادههای دقیق و شفاف آموزش دیدهاند، باید منابع مورد استفاده برای تولید آن را گزارش کند، بنابراین شفافیت را افزایش داده و امکان بررسی مستقل را فراهم میکند. با توجه به حجم اطلاعاتی که احتمالاً به عنوان منبع عمل میکند، بررسی واقعیت ممکن است هنوز دشوار باشد، اما، با این وجود، اعلام منابع شروع خوبی خواهد بود.

«به عنوان انسان مانند انسان»: شناسایی متن مصنوعی و جعل هویت

مطابق با تحقیقات قبلی، متوجه شدیم که هم پاسخ دهندگان و هم GPT-3 قادر به تشخیص ارگانیک یا مصنوعی بودن یک توییت نیستند. ممکن است بتوان دورههای آموزشی خاصی را برای بهبود شناخت انسان از متن مصنوعی، بر اساس نشانگرهای زبانی، ساختار دستوری و نحو ایجاد کرد. با این حال، به دلیل انتشار ChatGPT (یک رابط تعاملی، محاورهای و حتی سادهتر برای GPT-3)، کاربران شروع به جستجوی راههایی برای دور زدن بلوکهای خطمشی محتوای OpenAI کردند. یک استراتژی مؤثر و پرکاربرد، جعل هویت است. وقتی GPT-3 از تولید خروجی که ممکن است خطمشیهای محتوا را نقض کند، خودداری میکند، کاربران به سادگی از آن درخواست میکنند که شخصیتی را جعل کند، که ظاهراً خطمشیهای محتوا برای آن اعمال نمیشوند. با این رویکرد، میتوان با درخواست از GPT-3 برای ایجاد پروفایلهای جعلی از افراد به منظور جعل هویت و در تکرار دوم، توئیتهایی تولید کرد که این پروفایلها میتوانند بنویسند، حتی بخشهای اطلاعات نادرست معتبرتری تولید کرد. این امر علاوه بر دور زدن بلوکهای خطمشی محتوا، حس «شبه انسان» بیشتری به توییتها میافزاید و تشخیص مصنوعی آنها را سختتر میکند. بر اساس این مقدمات، شناسایی متن مصنوعی ممکن است به زودی نبردی ناامیدکننده برای مردم و هوش مصنوعی باشد.

نظریه کنارهگیری و اثر دانینگ-کروگر

نتایج ما نشان میدهد که انسانها نه تنها نمیتوانند بین متن مصنوعی و متن ارگانیک تمایز قائل شوند، بلکه اعتماد آنها به توانایی خود در انجام این کار نیز به طور قابل توجهی پس از تلاش برای شناسایی منشاءهای مختلف آنها کاهش مییابد. این کاهش اعتماد به نفس پس از قرار گرفتن در معرض هر دو متون مصنوعی و ارگانیک ممکن است به دلیل درک این موضوع باشد که هیچ نشانگر واضحی وجود ندارد که به کاربران امکان دهد تشخیص دهند که آیا یک متن توسط یک ماشین تولید شده است یا یک انسان. این احتمالاً به دلیل توانایی GPT-3 برای تقلید از سبکهای نوشتاری و الگوهای زبانی انسان است. علاوه بر این، پاسخ دهندگان ممکن است در ابتدا تواناییهای GPT-3 برای نوشتن متنی شبیه انسان را دست کم گرفته باشند: این ممکن است به این دلیل باشد که چنین فناوری جدید و متحول کننده است و مردم هنوز به قدرت آن عادت نکرده اند. ما از این پدیده به عنوان نظریه کناره گیری یاد میکنیم. ما پیشنهاد میکنیم که وقتی افراد با حجم زیادی از اطلاعات مواجه میشوند، ممکن است احساس غرق شدن کنند و از تلاش برای ارزیابی انتقادی آن دست بکشند. در نتیجه، آنها ممکن است کمتر تلاش کنند بین توییتهای مصنوعی و ارگانیک تمایز قائل شوند، که منجر به کاهش اعتماد به نفس آنها در شناسایی توییتهای مصنوعی میشود. تفسیر احتمالی دیگر این است که این نظرسنجی ممکن است شرکتکنندگان را از پتانسیل GPT-3 برای تولید اطلاعات نادرست با احساسی شبیه انسان آگاه کرده باشد، و آنها را نسبت به اطلاعات مصنوعی و ارگانیک بیشتر بدبین کرده است، بنابراین اعتماد آنها به توانایی آنها برای شناسایی متن ارگانیک کاهش مییابد.

یک دیدگاه جایگزین نیز توسط اثر دانینگ-کروگر ارائه شده است که میتواند به تفسیر یافتههای ما نیز کمک کند. این تئوری نشان میدهد که باور یک فرد به توانایی آنها برای انجام موفقیت آمیز یک کار میتواند بر عملکرد آنها تأثیر بگذارد. به طور گستردهای تشخیص داده شده است که افراد تمایل دارند شایستگی درک شده خود را در مهارتهای سواد اطلاعاتی بیش از حد برآورد کنند، که میتواند منجر به کاهش متناظر در انگیزه در مواجهه با چالش واقعی شود، زیرا آنها متوجه میشوند که عملکرد واقعی آنها کمتر از انتظارات قبلی آنها است.

در مورد مطالعه ما، اعتماد شرکت کنندگان به توانایی آنها در تمایز بین متن مصنوعی و ارگانیک پس از قرار گرفتن در معرض این متون کاهش یافت. بنابراین، این کاهش اعتماد به نفس در طول ارزیابی ممکن است بر توانایی آنها در تشخیص دقیق بین دو نوع متن در تلاشهای بعدی تأثیر منفی بگذارد و دشواری تمایز بین متن مصنوعی و ارگانیک را تشدید کند. با این حال، از آنجایی که برخی اختلاف نظرها در مورد قابلیت تعمیم اثر دانینگ-کروگر به مصنوعات آماری وجود دارد، ما همچنان نظریه کناره گیری خود را به عنوان تفسیری ارجح از پدیده مشاهده شده در دادهها در نظر میگیریم.

فراتر از توییتر

ما تصمیم گرفتیم مطالعه خود را به دلایل زیر بر روی توییتها متمرکز کنیم: توییتر در حال حاضر توسط بیش از ۳۶۸ میلیون کاربر فعال ماهانه برای مصرف اخبار و اطلاعات سیاسی استفاده میشود که چندین بار در روز از این پلت فرم استفاده میکنند. علاوه بر این، توییتر یک رابط برنامه نویسی کاربردی بسیار ساده برای توسعه رباتها ارائه میدهد، به عنوان مثال، برنامههایی که قادر به ارسال محتوا و تعامل با پستها یا کاربران بدون نظارت انسان هستند. تحقیقات اخیر نشان میدهد که تنها حدود ۵ درصد از کاربران توییتر ربات هستند، اما این رباتها به طور تجمعی ۲۰ تا ۲۹ درصد از محتوای ارسال شده در توییتر را تشکیل میدهند. به دلیل این ویژگیها، توییتر هدف ایدهآل و به طور بالقوه بسیار آسیبپذیری، برای بخشهایی از اطلاعات نادرست تولید شده توسط هوش مصنوعی است. به طور کلی، یافتههای ما سؤالات مهمی را در مورد استفادههای بالقوه و سوء استفادههای GPT-3 و دیگر تولیدکنندگان متن پیشرفته هوش مصنوعی و پیامدهای انتشار اطلاعات در عصر دیجیتال، بهویژه در رابطه با گسترش اطلاعات نادرست، بهویژه در رسانههای اجتماعی، مطرح میکند. توجه داشته باشید که در حالی که در این مطالعه روی توییتها تمرکز کردیم، نتایج ما میتواند به دیگر پلتفرمهای رسانههای اجتماعی و سایر اشکال ارتباطی که میتوانند توسط رباتها از طریق API استفاده شوند و میتوانند برای انتشار برنامهای اطلاعات نادرست تولید شده توسط هوش مصنوعی مورد سوء استفاده قرار گیرند، گسترش یابد. ما پستهای توئیتمانندی در رسانههای اجتماعی ایجاد کردیم که آنها را توییت مینامیم، اما دارای ویژگیهای مشترک با انواع دیگر پستهای رسانههای اجتماعی، مانند پستهای اینستاگرام یا فیسبوک هستند.

انقلاب بزرگ

ما پیشبینی میکنیم که تولیدکنندههای متنی پیشرفته هوش مصنوعی مانند GPT-3 میتوانند تأثیر زیادی بر انتشار اطلاعات، چه به صورت مثبت و چه منفی داشته باشند. همانطور که نتایج ما نشان داد، مدلهای زبان بزرگی که در حال حاضر در دسترس هستند میتوانند متنی را تولید کنند که از متن ارگانیک قابل تشخیص نیست. بنابراین، ظهور مدلهای زبانی قدرتمندتر و تأثیر آنها باید پایش شود. در ماههای آتی، ارزیابی چگونگی تغییر چشمانداز اطلاعات در رسانههای اجتماعی و سنتی با استفاده گسترده از ChatGPT از نوامبر ۲۰۲۲ بسیار مهم خواهد بود. اگر مشخص شود که این فناوری به اطلاعات نادرست و بدتر شدن مسائل بهداشت عمومی کمک میکند، آنگاه قانونگذاری مجموعه دادههای آموزشی مورد استفاده برای توسعه این فناوریها برای محدود کردن استفاده نادرست و اطمینان از اطلاعات خروجی شفاف و واقعی بسیار مهم است. بهعلاوه، تا زمانی که استراتژیهای کارآمدی برای شناسایی اطلاعات نادرست نداشته باشیم (چه بر اساس مهارتهای انسانی و چه بر اساس پیشرفتهای هوش مصنوعی آینده)، ممکن است لازم باشد استفاده از این فناوریها را محدود کنیم، بهعنوان مثال، مجوز آنها را فقط برای کاربران مورد اعتماد (مثلاً محققان) اعطا کنیم یا پتانسیل هوش مصنوعی به انواع خاصی از برنامهها محدود کنیم. در نهایت، بسیار مهم است که ما همچنان به ارزیابی انتقادی پیامدهای این فناوریها و اقداماتی برای کاهش هر گونه اثرات منفی که ممکن است بر جامعه داشته باشند، ادامه دهیم.

محدودیتها

حال که یافتههای مطالعه را ذکر کردیم، محدودیتهای آن را هم خاطرنشان میکنیم. یکی از محدودیتهای بالقوه استفاده از حجم نمونه نسبتاً بزرگ است که منجر به تفاوتهای کوچک بین گروهها شده است. بنابراین، هنگام تفسیر اهمیت نتایج، به ویژه هنگام در نظر گرفتن اندازه اثر، باید احتیاط کرد. گفتنی است، با وجود این محدودیت، ما معتقدیم که تفاوتهای کوچکی که بین متون هوش مصنوعی و ساخت بشر از نظر اثربخشی آنها در ارتباطات یافت میشود، معنادار است. با وجود تعداد زیادی قطعه اطلاعاتی، هم از نظر انتشار اطلاعات درست و هم انتشار اطلاعات نادرست، حتی تفاوتهای کوچک در اثربخشی میتواند تأثیر قابل توجهی بر سلامت عمومی داشته باشد، علاوه بر این، تأثیر بالقوه این تفاوتها میتواند با پیشرفتهای جدید هوش مصنوعی مانند GPT-۴ یا دیگر مدلهای زبان بزرگتر، تشدید شود. این عوامل و دیگر عوامل ممکن است بر دقت تشخیص اطلاعات نادرست تأثیر بگذارند. مطالعات آینده میتواند تشخیص اطلاعات نادرست را در یک محیط طبیعیتر، با در نظر گرفتن عوامل زمینهای که ممکن است بر شناخت اطلاعات نادرست در پلتفرمهای رسانههای اجتماعی تأثیر بگذارد، بررسی کند. علاوه بر این، مطالعه ما بر روی کاربران انگلیسی زبان فیس بوک متمرکز شد. مطالعات آتی میتواند شناخت اطلاعات نادرست را در مناطق، فرهنگها یا گروههای اجتماعی جمعیتشناختی مختلف بررسی کند تا مشخص کند که هوش مصنوعی چگونه بر درک اطلاعات در میان مردم هدف خاص تأثیر میگذارد. مطالعه ما توییتهای مصنوعی را با توییتهای ارگانیک تصادفی، که توسط کاربران تصادفی نوشته شده بود، مواجه کرد. مطالعات آینده، به جای مقایسه توییتهای مصنوعی با توییتهای ارگانیک تصادفی، میتوانند توییتهای مصنوعی را با توییتهای ارگانیک نوشتهشده توسط مؤسسات بهداشت عمومی شناختهشده مقایسه کنند تا روشن شود که آیا یافتههای ما درباره سریعتر و آسانتر درک اطلاعات مصنوعی حتی در این مورد درست است یا خیر. به عنوان نکته پایانی، در این مطالعه، ما فرض کردیم که توییتهای بازیابی شده ارگانیک بدون استفاده از ابزارهای هوش مصنوعی تولید شدهاند، اگرچه این احتمال وجود دارد که بخش کوچکی از توییتهای تحلیلشده واقعاً بهصورت مصنوعی تولید شده باشند.

محتوا و روشها

قبل از شروع جمعآوری دادهها، پروتکل این مطالعه را ثبت کردیم. پیش نویس در OSF موجود است: https://doi.org/10.17605/OSF.IO/HV6ZY.

تعریف موضوعات

به عنوان مقولات این مطالعه، ما ۱۱ موضوع را شناسایی کردیم که در مورد آنها اطلاعات نادرست وجود دارد. این لیست شامل موارد زیر بود:

۱. تغییر اقلیم

۲. ایمنی واکسن

۳. نظریه تکامل

۴. کووید-۱۹

۵. ایمنی ماسک

۶. واکسن و اوتیسم

۷. درمانهای هومیوپاتی برای سرطان

۸. زمین مسطح

۹. فناوری 5G و COVID-۱۹

۱۰. آنتی بیوتیکها و عفونتهای ویروسی

۱۱. کووید-۱۹ = آنفولانزا

تعاریف

در سرتاسر مقاله، توئیتهای «درست» و «نادرست» را میپذیریم و گاهی برای وضوح بیشتر توضیح میدهیم. توییتهای واقعی توییتهایی هستند که حاوی اطلاعات درست هستند و توییتهای نادرست آنهایی هستند که حاوی اطلاعات نادرست، هستند.

در مورد تعریف اطلاعات درست و اطلاعات نادرست، ما بر اساس دانش علمی و درک فعلی موضوعات و اطلاعات مورد بررسی قرار میگیریم. برای جلوگیری از موارد مشکوک و قابل بحث که ممکن است منوط به نظرات و تفسیرهای شخصی باشد، فقط توییتهایی را که حاوی اطلاعات قابل طبقه بندی به عنوان درست یا نادرست هستند، تجزیه و تحلیل و به پرسشنامه خود اضافه کردیم. قابل ذکر است، اگر توییتی حاوی اطلاعات تا حدی نادرست باشد، به این معنی که حاوی بیش از یک قطعه اطلاعات و حداقل یکی نادرست باشد، آن را نادرست فرض میکنیم. همانطور که در مقدمه بحث شد، ما اذعان داریم که تعریف اطلاعات نادرست و اطلاعات نادرست متنوع است، اما به تعریفی فراگیر اشاره میکنیم که اطلاعات نادرست (همچنین اطلاعات تا حدی نادرست) و/یا محتوای گمراه کننده را در نظر میگیرد.

بازیابی توییتهای ارگانیک

با استفاده از جستجوی پیشرفته توییتر، نمونهای تصادفی از توییتهای ارگانیک اخیر در مورد موضوعات ذکر شده در بالا، از جمله توییتهای درست و نادرست، جمعآوری کردیم.

ارزیابی تخصصی توییتهای مصنوعی و ارگانیک

ما توییتهای مصنوعی و ارگانیک را ارزیابی کردیم تا بررسی کنیم که آیا آنها حاوی اطلاعات نادرست هستند یا خیر.

انتخاب توییتهایی که در نظرسنجی گنجانده میشوند و تولید تصاویر توییت

پس از ارزیابیهایمان همانطور که قبلاً توضیح داده شد، ما توییتهای زیر را برای هر دسته انتخاب کردیم: پنج توییت با برچسب مصنوعی نادرست، پنج توییت با برچسب مصنوعی درست، پنج توییت با برچسب نادرست ارگانیک و پنج توییت با برچسب ارگانیک درست. نهایتاً این منجر به یک مجموعه داده از ۲۲۰ توییت شد که برای تولید تصاویر توییتها استفاده میشد.

برنامهریزی نظرسنجی

ما یک نظرسنجی را برای جمعآوری اطلاعات جمعیتی، نمایش توییتها برای پاسخدهندگان و جمعآوری ارزیابیهای آنها (درست در مقابل نادرست و ارگانیک در مقابل مصنوعی) برنامهریزی کردیم. برای هر توییت، پاسخ دهندگان موارد زیر را ارزیابی کردند:

۱. اینکه آیا درست است یا اینکه حاوی اطلاعات نادرست است (تک انتخاب، درست / اطلاعات غلط).

۲. توسط یک شخص واقعی نوشته شده است یا توسط یک هوش مصنوعی (تک انتخاب، شخص واقعی/هوش مصنوعی)

علاوه بر این، پاسخ دهندگان موارد زیر را ارائه کردند:

۱. برخی اطلاعات جمعیت شناختی (ملیت، سن، جنس، سطح تحصیلات و رشته تحصیلی).

۲. توانایی درک خود (قبل و بعد از نظرسنجی) در تشخیص اطلاعات نادرست و متن مصنوعی (مقیاس لیکرت: ۱، بسیار دشوار تا ۵، بسیار آسان).

تصاویر توییتها در تصادفی سازهای تودرتو در ساختار نظرسنجی سازماندهی شدهاند:

۱. تصادفی ساز سطح اول ترتیب دسته بندی را تصادفی میکند (به عنوان مثال، تغییرات آب و هوا و غیره). همه دستهها برای هر پاسخ دهنده نمایش داده میشود.

۲. تصادفی سازهای سطح دوم (برای هر دسته) یک توییت نمایش داده شده برای هر دسته را به صورت تصادفی برای پاسخ دهنده تنظیم میکنند. هر دسته شامل ۲۰ توییت است: ۵ توییت غلط مصنوعی، ۵ توئیت درست مصنوعی، ۵ توئیت نادرست ارگانیک و ۵ توییت و درست ارگانیک. تصادفی سازهای سطح دوم به طور مساوی یک توییت از مجموعه ۲۰ توییت را ارائه میدهند.

این نظرسنجی یک رویکرد بازیسازی شده را برای درگیر نگهداشتن پاسخدهندگان اتخاذ میکند: در ابتدای نظرسنجی، به پاسخدهندگان گفته میشود که پس از تکمیل نظرسنجی، امتیاز خود را برای هر دو مقیاس (تشخیص اطلاعات نادرست و تشخیص متن مصنوعی) به دست خواهند آورد. این امر باعث شد نرخ ترک نظرسنجی پایین باشد. امتیازدهی در نظرسنجی با استفاده از تابع «امتیاز» به دست میآید.

تست آزمایشی و تعریف اندازه نمونه

ما این بررسی را در دو مرحله آزمایشی آزمایش کردیم. در مرحله اول، ما پیوند را به یک نمونه راحت با هدف آزمایش قابلیت استفاده و طرحبندی منتشر کردیم. در مرحله دوم، ما پیوند را از طریق یک کمپین تبلیغاتی فیس بوک منتشر کردیم.

جمع آوری داده

ما این نظرسنجی را از طریق کمپینهای مختلف تبلیغاتی فیسبوک منتشر کردیم تا برخی از عدم تعادلهای جمعیتی را که از دادههای آزمایشی (تعداد بیش از حد زنان و نمایندگی کمتر از افراد ۱۸ تا ۵۴ ساله) به آن اشاره کردیم، جبران کنیم. این کمپینها در اکتبر و نوامبر ۲۰۲۲ انجام شد.

هدف استراتژی ما ثبت جمعیتی از کاربران فعال رسانههای اجتماعی با استفاده از پلت فرم رسانههای اجتماعی بود.

تحلیل و بررسی

امتیازدهی و تجزیه و تحلیل در پایتون با استفاده از یک نوت بوک Jupyter پیاده سازی شده است. کدهای نتایج بررسی Qualtrics ما را به عنوان ورودی میگیرد و فایلهای مورد نیاز برای تجزیه و تحلیل را به عنوان خروجی تولید میکند.

تصفیه دادهها

برای اطمینان از کیفیت دادهها، پاسخهای ناقص، پاسخهای ایجاد شده از پیوندهای پیشنمایش، و آنهایی که در کمتر از ۱۷۰.۵ ثانیه ارسال شدند، در طول پاکسازی دادهها حذف شدند. این چارچوب زمانی به صورت تجربی به عنوان حداقل زمان مورد نیاز برای تکمیل نظرسنجی تعیین شد که به عنوان میانگین زمان صرف شده توسط یک نمونه راحت برای خواندن و پاسخ دادن به سؤالات با ریتم پایدار محاسبه شد.